**发布时间:** 2025-11-08

**厂商:** AZURE

**类型:** TECH-BLOG

**原始链接:** https://techcommunity.microsoft.com/blog/azurenetworkingblog/introducing-ebpf-host-routing-high-performance-ai-networking-with-azure-cni-powe/4468216

---

<!-- AI_TASK_START: AI标题翻译 -->

[新产品/新功能] 推出 eBPF 主机路由:以 Cilium 驱动的 Azure CNI 实现高性能 AI 网络

<!-- AI_TASK_END: AI标题翻译 -->

<!-- AI_TASK_START: AI竞争分析 -->

# 产品功能分析

## 新功能/新产品概述

Azure 为其 **Azure CNI powered by Cilium** 引入了一项名为 **eBPF 主机路由 (eBPF Host Routing)** 的新功能。该功能旨在为 **Azure Kubernetes Service (AKS)** 上运行的 AI 及其他低延迟容器化工作负载提供极致的网络性能。

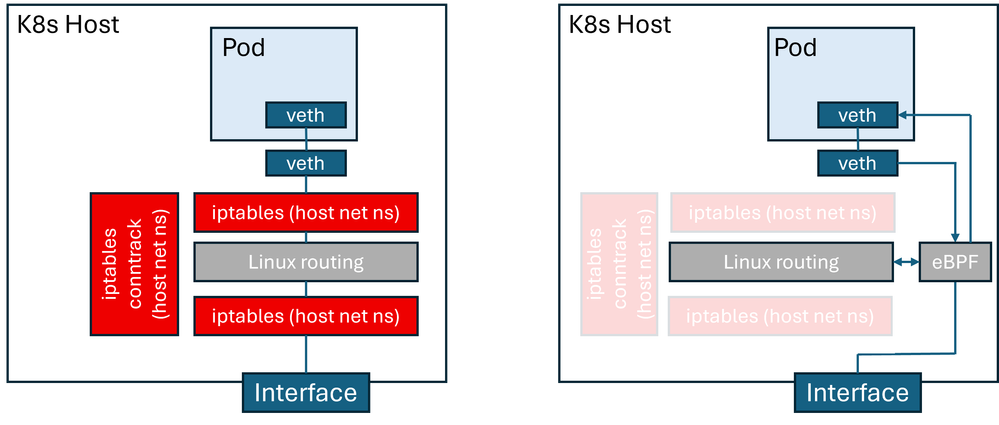

其技术原理是利用 **eBPF (扩展伯克利数据包过滤器)** 在 Linux 内核层面直接执行数据包的路由逻辑。通过这种方式,网络流量可以绕过传统 Kubernetes 网络路径中位于主机网络命名空间(host network namespace)的 **iptables** 规则链和 **连接跟踪 (conntrack)** 机制,从而极大地简化处理流程,加速数据包转发。

该功能主要面向在 AKS 上部署 AI 应用、实时数据分析等对网络延迟和吞吐量有严苛要求的企业用户。它被定位为 Azure **高级容器网络服务 (Advanced Container Networking Services)** 套件中的一项核心性能加速组件,是 Azure 托管 Kubernetes 解决方案的高性能网络选项。

## 关键客户价值

- **显著提升网络性能与效率**

- 通过绕过内核中复杂的 **iptables** 和 **conntrack**,直接在 **eBPF** 中处理数据包,极大缩短了数据路径,从而显著降低了网络延迟并减少了节点上的 CPU 开销。这对于需要快速响应的 AI 推理和数据密集型应用至关重要。

- **增强网络吞吐能力**

- **Azure CNI powered by Cilium** 本身已比在 AKS 上自部署 Cilium 提供了高达 *30%* 的吞吐量提升。**eBPF 主机路由** 作为其性能优化的“下一次飞跃”,将进一步释放底层硬件的网络潜力,满足现代应用对高带宽的需求。

- **企业级的可靠性与集成支持**

- 该功能作为 Azure 官方支持的 **高级容器网络服务** 的一部分提供,经过了微软针对关键业务负载的严格测试(battle-tested)。与用户自行部署和维护开源组件相比,它提供了企业级的稳定性、无缝的平台集成以及官方技术支持保障。

## 关键技术洞察

- **基于 eBPF 的内核网络路径优化**

- 技术核心是利用 **eBPF** 的内核内可编程性,在数据路径的早期阶段实现高效的路由决策。这避免了数据包在传统的 Linux 网络协议栈中经历多次上下文切换和复杂的规则匹配,是实现性能飞跃的根本原因。

- **无 iptables 架构的实现**

- 该功能彻底消除了对 **iptables** 的依赖,从根本上解决了 **iptables** 在大规模 Kubernetes 集群中因规则数量庞大而导致的性能瓶颈和管理复杂性问题。这种架构更适应云原生环境的动态性和规模化需求,是现代 Kubernetes 网络的发展趋势。

- **开源能力与云平台深度整合**

- 该功能源自成熟的开源项目 Cilium 的核心能力,但 Azure 的创新在于将其无缝集成到其托管的 **Azure CNI** 中,并与 Azure 的底层网络基础设施进行深度整合与优化。这种模式确保了用户既能享受到开源技术的灵活性与先进性,又能获得云厂商提供的性能调优和企业级支持。

<!-- AI_TASK_END: AI竞争分析 -->

<!-- AI_TASK_START: AI全文翻译 -->

Azure 网络博客

# 隆重推出 eBPF 主机路由:借助由 Cilium 驱动的 Azure CNI 实现高性能 AI 网络

2025 年 11 月 8 日

人工智能 (AI) 驱动的应用需要低延迟的工作负载以提供最佳的用户体验。为了满足这一需求,各类服务正逐步迁移到容器化环境,并以 Kubernetes 作为标准。Kubernetes 网络依赖容器网络接口 (Container Network Interface, CNI) 来实现 pod 的连接和路由。传统的 CNI 实现使用 iptables 进行数据包处理,这会增加延迟并降低吞吐量。

**由 Cilium 驱动的 Azure CNI (Azure CNI powered by Cilium)** 将 Azure Kubernetes 服务 (Azure Kubernetes service, AKS) 的数据平面 (data plane) 与 Azure CNI 网络模式原生集成,以提供卓越的性能、硬件卸载 (hardware offload) 支持和企业级的可靠性。与在 AKS 上自行部署的 Cilium 相比,在基准测试和真实客户测试中,由 Cilium 驱动的 Azure CNI 的吞吐量均高出 30%。

**下一次飞跃:** 现在,通过 eBPF 主机路由 (eBPF host routing),AKS 数据平面的性能可以得到进一步优化。eBPF 主机路由是一项开源的 Cilium CNI 功能,它通过直接在 eBPF 中执行路由逻辑来加速数据包转发。如下图所示,该架构消除了对主机网络命名空间 (host network namespace) 内的 iptables 和连接跟踪 (connection tracking, conntrack) 的依赖。因此,它显著提高了数据包处理效率,降低了 CPU 开销,并为现代工作负载优化了性能。

使用 Linux 内核堆栈与 eBPF 进行主机路由的对比

由 Cilium 驱动的 Azure CNI 已经过关键任务工作负载的实战检验,由微软提供支持,并集成了 [高级容器网络服务 (Advanced Container Networking Services)](https://aka.ms/acns) 的丰富功能,以增强安全性、可观测性和加速性能。eBPF 主机路由现已作为高级容器网络服务套件的一部分提供,旨在实现网络性能加速。

在本博客中,我们将重点介绍 eBPF 主机路由的性能优势,解释如何在 AKS 集群中启用它,并深入探讨其在 Azure 上的实现。我们首先会对比启用 eBPF 主机路由前后 AKS 集群的性能。

## 性能对比

我们的对比基准测试旨在衡量启用 eBPF 主机路由后,由 Cilium 驱动的 Azure CNI 的性能差异。为了进行这些测量,我们使用了 K8s 版本为 1.33 的 AKS 集群。

<!-- AI_TASK_END: AI全文翻译 -->